Der OpenAI Dev Day 2024 hat die KI-Welt erneut in Aufruhr versetzt. Mit bahnbrechenden Innovationen und Verbesserungen setzt OpenAI neue Maßstäbe in der Entwicklung und Anwendung künstlicher Intelligenz. In diesem Artikel tauchen wir tief in die wichtigsten Neuerungen ein, die auf dem OpenAI Dev Day 2024 vorgestellt wurden und zeigen auf, wie sie die Arbeit von Entwicklern und Unternehmen revolutionieren werden.

Einleitung: OpenAI Dev Day 2024 – Ein Meilenstein der KI-Evolution

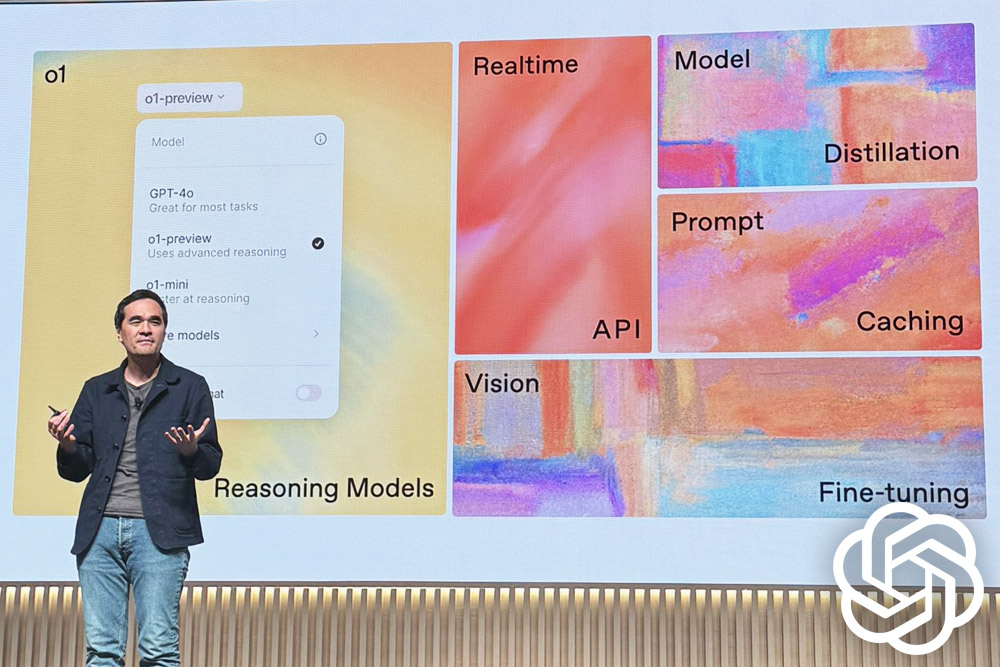

Der OpenAI Dev Day 2024 markiert einen bedeutenden Wendepunkt in der Geschichte der künstlichen Intelligenz. Die vorgestellten Technologien versprechen nicht nur Leistungssteigerungen, sondern auch neue Möglichkeiten für Effizienz, Kosteneinsparungen und innovative Anwendungen. Von Prompt Caching über Model Distillation bis hin zur Realtime API – die Neuerungen des OpenAI Dev Day 2024 werden die Art und Weise, wie wir KI entwickeln und einsetzen, grundlegend verändern.

Prompt Caching: Schnellere und kostengünstigere KI-Anfragen

Eine der herausragenden Innovationen des OpenAI Dev Day 2024 ist das Prompt Caching. Diese Technologie verspricht, die Verarbeitung von KI-Anfragen erheblich zu beschleunigen und gleichzeitig die Kosten zu senken.

Was ist Prompt Caching?

Prompt Caching ist eine Methode, bei der häufig verwendete Teile von Modellprompts zwischengespeichert werden. Dies ermöglicht es, API-Anfragen an Server zu leiten, die kürzlich ähnliche Prompts verarbeitet haben, anstatt jedes Mal von Grund auf zu beginnen.

Vorteile des Prompt Cachings:

- Latenzreduzierung: Bis zu 80% geringere Latenzzeiten bei der Verarbeitung von Anfragen.

- Kosteneffizienz: Kosteneinsparungen von bis zu 50% bei langen Prompts.

- Automatische Implementierung: Funktioniert ohne zusätzliche Codeänderungen für alle API-Anfragen.

Funktionsweise und Anforderungen:

- Caching wird automatisch für Prompts mit 1024 Token oder mehr aktiviert.

- Cache-Treffer erfolgen in Schritten von 128 Token.

- Gecachte Präfixe bleiben in der Regel 5 bis 10 Minuten aktiv, in Zeiten geringer Auslastung bis zu einer Stunde.

Best Practices für Entwickler:

- Strukturieren Sie Prompts mit statischem Inhalt am Anfang und dynamischem Inhalt am Ende.

- Überwachen Sie Metriken wie Cache-Trefferquoten und Latenzzeiten zur Optimierung.

- Verwenden Sie längere Prompts und senden Sie API-Anfragen in Zeiten geringer Auslastung für höhere Cache-Trefferquoten.

- Halten Sie einen konstanten Strom von Anfragen mit ähnlichen Prompt-Präfixen aufrecht, um Cacheverdrängungen zu minimieren.

Model Distillation: Kleinere Modelle, große Leistung

Eine weitere bahnbrechende Technologie, die auf dem OpenAI Dev Day 2024 vorgestellt wurde, ist die Model Distillation. Diese Methode ermöglicht es, die Leistungsfähigkeit großer Modelle auf kleinere zu übertragen, was sowohl Effizienz als auch Kostenvorteile mit sich bringt.

Was ist Model Distillation?

Model Distillation ist ein Prozess, bei dem die Ausgaben eines großen Modells genutzt werden, um ein kleineres Modell für spezifische Aufgaben zu optimieren. Ziel ist es, ähnliche Leistungen bei geringerem Ressourcenverbrauch zu erzielen.

Der Distillationsprozess in vier Schritten:

- Generierung hochwertiger Ausgaben: Nutzen Sie ein großes Modell wie `o1-preview` oder `gpt-4o`, um qualitativ hochwertige Ergebnisse zu erzeugen und zu speichern.

- Baseline-Evaluation: Vergleichen Sie die Leistung des großen und des kleinen Modells anhand der gespeicherten Ausgaben.

- Trainingsdatensatz erstellen: Wählen Sie eine Teilmenge der gespeicherten Ausgaben als Trainingsdaten für das kleinere Modell aus.

- Fine-Tuning und Evaluation: Führen Sie das Fine-Tuning des kleineren Modells durch und evaluieren Sie seine Leistung im Vergleich zum großen Modell.

Vorteile der Model Distillation:

- Kosteneffizienz: Kleinere Modelle benötigen weniger Rechenressourcen.

- Geringere Latenz: Schnellere Antwortzeiten durch effizientere Modelle.

- Spezialisierung: Optimierung für spezifische Aufgaben bei gleichbleibender Qualität.

Vision Fine-tuning: KI lernt sehen

Der OpenAI Dev Day 2024 brachte auch bedeutende Fortschritte im Bereich der visuellen KI. Mit der Einführung des Vision Fine-tunings eröffnen sich völlig neue Möglichkeiten für die Bildverarbeitung und -analyse.

Was ist Vision Fine-tuning?

Vision Fine-tuning erweitert die bekannten Fine-Tuning-Techniken auf den Bereich der Bildverarbeitung. Es ermöglicht Entwicklern, Modelle speziell für visuelle Aufgaben zu optimieren und anzupassen.

Wichtige Einschränkungen und Überlegungen:

- Maximale Anzahl von Bildbeispielen: 50.000 pro Trainingsdatei

- Höchstens 10 Bilder pro Beispiel

- Maximale Bildgröße: 10 MB

- Nur RGB- oder RGBA-Bilder sind zulässig

- Keine Bilder als Ausgabe von Assistant-Nachrichten

Datenschutz und Inhaltsmoderation:

- Trainingsdateien dürfen keine Personenbilder, Gesichter, CAPTCHAs oder Bilder enthalten, die gegen die Nutzungsbedingungen verstoßen.

- Datensätze mit solchen Bildern werden automatisch abgelehnt.

Realtime API: Echtzeitkommunikation neu definiert

Als Höhepunkt des OpenAI Dev Day 2024 wurde die Realtime API vorgestellt. Diese bahnbrechende Technologie ermöglicht es Entwicklern, Konversationserfahrungen mit geringer Latenz und multimodaler Unterstützung zu schaffen.

Hauptmerkmale der Realtime API:

- Native Sprache-zu-Sprache-Verarbeitung: Eliminiert Textintermediäre für minimale Latenz und nuancierte Ausgaben.

- Natürliche, steuerbare Stimmen: Modelle mit natürlicher Intonation, die lachen, flüstern und Tonvorgaben folgen können.

- Simultane multimodale Ausgabe: Text für Moderation, schneller als Echtzeit-Audio für stabile Wiedergabe.

Technische Details zur Implementierung:

- Verbindung: WebSocket-Verbindung zu wss://api.openai.com/v1/realtime

- Erforderliche Parameter:

- URL: wss://api.openai.com/v1/realtime

- Query-Parameter: ?model=gpt-4o-realtime-preview-2024-10-01

- Headers:

- Authorization: Bearer YOUR_API_KEY

- OpenAI-Beta: realtime=v1

Kernkonzepte der Realtime API:

- Session: Repräsentiert die gesamte Client-Server-Interaktion mit Standardkonfigurationen.

- Conversation: Besteht aus einer Liste von Items (Nachrichten, Funktionsaufrufe, etc.).

- Items: Können Nachrichten, Funktionsaufrufe oder Funktionsausgaben sein.

- Input Audio Buffer: Speichert vom Client bereitgestelltes Audio, das noch nicht in den Konversationszustand übernommen wurde.

Funktionsaufrufe und Audio-Integration:

- Funktionen können als Tools im Chat Completions API-Format übergeben werden.

- Server kann Funktionen aufrufen und gleichzeitig mit Audio und Text antworten.

- Zwei Modi für die Spracherkennung: Server VAD (Voice Activity Detection) und No Turn Detection.

Fazit: Die Zukunft der KI beginnt jetzt

Der OpenAI Dev Day 2024 hat eindrucksvoll gezeigt, dass die Entwicklung künstlicher Intelligenz unaufhaltsam voranschreitet. Mit Innovationen wie Prompt Caching, Model Distillation, Vision Fine-tuning und der Realtime API setzt OpenAI neue Maßstäbe in Bezug auf Effizienz, Leistungsfähigkeit und Anwendungsmöglichkeiten von KI-Systemen.

Diese Technologien werden nicht nur die Arbeit von Entwicklern revolutionieren, sondern auch völlig neue Anwendungsfelder für KI in verschiedensten Branchen eröffnen. Von schnelleren und kostengünstigeren Modellen über spezialisierte visuelle KI-Assistenten bis hin zu nahtlosen Echtzeit-Konversationsschnittstellen – die Möglichkeiten scheinen grenzenlos.

Als Entwickler und KI-Enthusiasten stehen wir am Anfang einer aufregenden Reise. Die auf dem OpenAI Dev Day 2024 vorgestellten Technologien sind nicht nur Werkzeuge, sondern Wegbereiter für eine Zukunft, in der KI noch tiefer in unser tägliches Leben integriert sein wird. Es liegt nun an uns, diese Werkzeuge kreativ und verantwortungsvoll einzusetzen, um Lösungen zu schaffen, die das Leben der Menschen verbessern und neue Horizonte in der Mensch-Maschine-Interaktion eröffnen.

Der OpenAI Dev Day 2024 war mehr als nur eine Präsentation neuer Technologien – er war der Startschuss für eine neue Ära der künstlichen Intelligenz. Lassen Sie uns gemeinsam diese aufregende Zukunft gestalten! Weitere Informationen können Sie hier finden.